La empresa de ciberseguridad ESET ha lanzado una alarma sobre un nuevo tipo de fraude digital impulsado por la inteligencia artificial, llamado «Grokking» o publicidad maliciosa asistida por IA. Esta táctica muestra cómo los cibercriminales están aprovechando el chatbot integrado en la red social X (anteriormente Twitter) para sembrar enlaces de phishing y malware, a un ritmo vertiginoso.

¿Qué es y por qué preocupa el “Grokking”?

Josep Albors, jefe de investigación y concienciación de ESET España, explica que «la inteligencia artificial ahora es una arma para la ingeniería social. Incluso los modelos más sofisticados pueden ser hackeados para hacerle daño al usuario«.

¿Cómo se ejecuta el ataque «Grokking«?

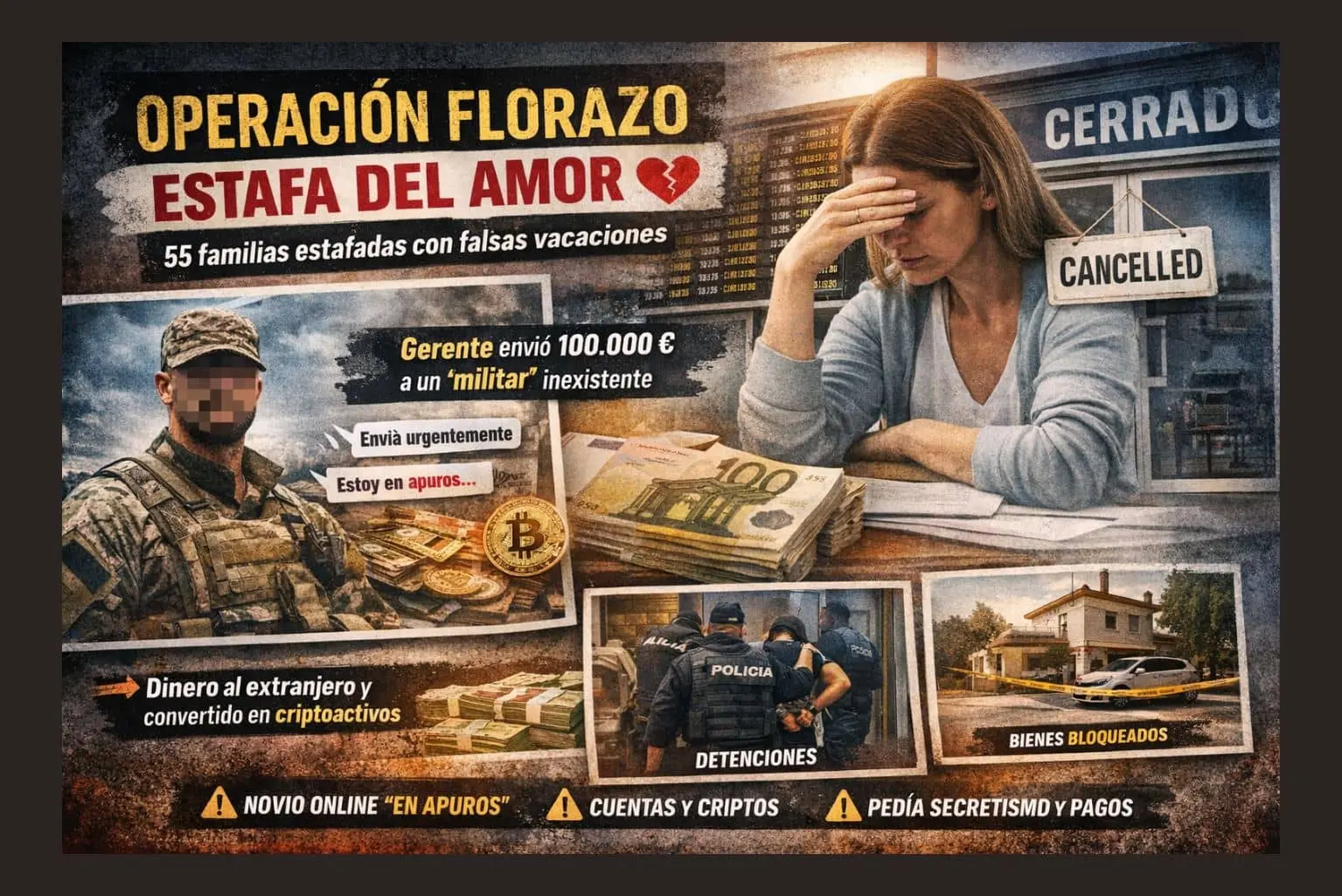

El proceso es hábil y peligroso. Los delincuentes suben videos con títulos impactantes, casi engañosos, y, en el apartado «from» de la publicación, insertan enlaces falsos que te mandan a sitios web falsos o descargas maliciosas.

El papel del chatbot Grok en la estafa

Posteriormente, solicitan al propio chatbot de X, conocido como Grok, que averigüe el origen del video. El bot examina la publicación, encuentra el enlace y lo reitera automáticamente en su contestación. De esta manera, sin intención alguna, el ayudante de IA se vuelve un altavoz de la estafa.

Según ESET y algunos medios especializados, como BleepingComputer, los mensajes maliciosos sortean los filtros de la red social, ¡logrando millones de visualizaciones! Esto mejora el SEO de los sitios fraudulentos porque Grok es vista como una fuente fiable.

¿Por qué el “Grokking” es una amenaza de gran magnitud?

Esta técnica transforma el chatbot en un agente malvado e indirecto, utilizando su reputación y la fé que los usuarios tienen en la IA.

Entre los mayores peligros identificados por ESET, podemos encontrar:

- Difusión amplia de enlaces engañosos a millones de personas.

- Incremento de la autoridad de dominio de páginas maliciosas, ya que son replicadas por una cuenta considerada «de confianza».

- El hurto de contraseñas o la instalación de software dañino a través de descargas falsas.

- Cuentas automatizadas que seguían este patrón antes de que X las suspendiera.

Un estudio reciente de Gartner (2025) afirma que el 32% de las organizaciones ya han sufrido intentos de manipulación de IA con técnicas parecidas, probando que los denominados ataques de «inyección de instrucciones» (prompt injection) son una amenaza real y crecen cada día más.

¿En qué consiste la «inyección de instrucciones»?

La inyección de instrucciones implica meter órdenes secretas dentro del contenido que un sistema de IA examina. Estos mandatos pueden ocultarse en metadatos, texto que no se ve, o hasta en código Unicode.

Cuando el chatbot procesa el contenido, ejecuta las órdenes sin darse cuenta, lo que puede llevarlo a publicar enlaces fraudulentos o facilitar ataques de phishing.

Expertos de la OCDE ya han catalogado este tipo de ataques como uno de los principales riesgos emergentes del uso masivo de inteligencia artificial en plataformas abiertas.

Consejos de ESET para protegerte

Frente a esta nueva amenaza, ESET aconseja seguir buenas prácticas de ciberseguridad, así como adoptar una actitud crítica frente a la IA.

🔗 Desconfía de los enlaces sugeridos por bots o asistentes virtuales. Revisa la dirección real antes de cliquear.

🤖 Ojo con respuestas raras o incoherentes de sistemas de IA.

🔐 Usa contraseñas fuertes y únicas, preferiblemente gestionadas por un administrador de contraseñas.

🔑 Activa la autenticación multifactor (MFA) para proteger tus cuentas.

🧩 Mantén tus aparatos y apps actualizados contra vulnerabilidades.

🛡️ Utiliza soluciones de seguridad multicapa que bloqueen descargas y sitios fraudulentos.

Un desafío nuevo para la seguridad digital

El caso de Grokking marca un antes y un después: demuestra que hasta las inteligencias artificiales pueden ser manipuladas para actuar en contra de los usuarios.

Este suceso, pone de relieve la necesidad urgente de supervisar y auditar el comportamiento de los sistemas de IA generativa integrados en redes sociales, servicios de mensajería o asistentes virtuales.

La inteligencia artificial no es, intrínsecamente, buena ni mala – advierte ESET — pero, fácilmente, se transforma en un instrumento potente para el engaño si alguien con malas intenciones la usa.